Happy New Year liebe Leserinnen und Leser, es geht munter weiter in der Welt der Maschinen und der künstlichen Intelligenz – mit der Frage, warum wir selbst nicht-lebendiges Zeug wie eine KI – z.B ChatGPT – in Geschlechterklischees zwängen. Da s Thema hatten wir ja hier schon öfter z.B hier und da und vor allem dort , aber es scheint einfach kein Ende nehmen zu wollen. Nun gut. Auf ein Neues wie man so schön sagt.

Wenn man sich ChatGPT als Person vorstellt, hat diese Person in der Fantasie vieler Menschen anscheinend eine Krawatte um den Hals und eine tiefe Stimme.

Klingt komisch? Vielleicht, aber laut der Studie von Jared Wong und Jin Kim (2023) neigen wir tatsächlich dazu, ChatGPT als männlich wahrzunehmen. Warum? Weil Kompetenz in unserer Gesellschaft oft mit Männlichkeit assoziiert wird – und Kompetenz ist nun einmal ChatGPTs Markenzeichen ( ob das nun stimmt oder nicht sei wie im realen Leben mal so dahingestellt, hihi)

Von „Herr ChatGPT“ zu „Frau Siri“

Nun, das Phänomen ist nicht neu: Schaut euch mal die Sprachassistenten an. Siri, Alexa, Cortana – alle Frauen bzw weiblich gelesen. Warum? Weil wir sie um Hilfe bitten. Und Hilfestellungen geben, nett sein und assistieren – also soziale Kompetenzen zu haben – ist ja etwas, was Frauen angeblich besonders gut können, nicht wahr? Also ein klassischer female stereotype. Aber stell dir mal vor, Alexa würde auf einmal sagen: „Ey, schalt dein Licht doch bitte selbst an.“ „Voll pushy die Alte“ und andere Dinge – die ich hier lieber mal nicht veröffentliche – hör ich den oder die imaginären Nutzer*in schon sagen. Wenn das wiederum ein Mann sagen würde naja.. da hätten wir sicher etwas mehr Verständnis bzw würden anders reagieren. Ich find das superspannend – und eben auch supererschreckend.

Zurück zu ChatGPT: ChatGPT gibt dagegen das Bild eines vielseitigen Universalgenies ab – zumindest, wenn man den Forscher*innen glaubt. Und weil es Informationen zusammenfasst und Probleme löst, assoziieren die Leute es eher mit einem Mann. Logisch, oder? Denn Kompetenz gehört zu Männern, genauso wie Fußball, Autos und das letzte Wort. Frauen? Die dürfen herzlich und vor allem bitte freundlich sein.

Das Muster passt gut zum Stereotype Content Model von Fiske et al. (2002). Laut diesem Modell beurteilen wir andere Menschen entlang der Dimensionen Kompetenz und Wärme. Da wurde auch schon darüber berichtet. Das geht unbewusst und superschnell. Sprich: Wir kriegen das nicht mit. Und: Wir machen das auch mit Maschinen – zumindest solchen die menschenähnliche Verhaltensweisen wie z.B Kommunizieren aufzeigen. KI wie ChatGPT wird aufgrund ihrer sachlichen und faktenorientierten Fähigkeiten als kompetent, aber weniger warm eingestuft, was typischerweise mit Männlichkeit assoziiert wird. Helau. Siri und Alexa hingegen, die durch so Dinge wie Freundlichkeit und Hilfsbereitschaft punkten, fallen in die Kategorie „warm, aber weniger kompetent“ – ein Stereotyp, das oft mit Weiblichkeit verknüpft ist. Klingt gar nicht verstaubt, n’est ce pas?

Die Studie zeigt noch was Spannendes: Wie man Chat GPT wahrnimmt, ist flexibel. Wenn es z.B dazu verwendet wird durch eine emotionale Krise zu helfen bzw zu unterstützen oder Mitgefühl zu zeigen, wird es plötzlich eine Sie. Sobald es aber den Unterschied zwischen KI und Machine Learning erklärt, ist es ein Er. Das sagt einiges darüber aus, wie stark wir Gender-Rollenbilder verinnerlicht haben.

Was sagt das nun über uns aus?

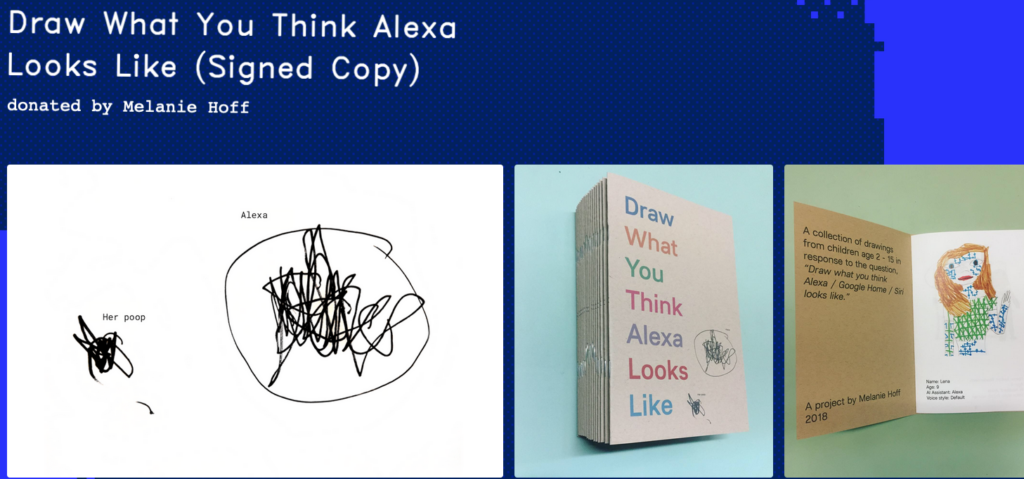

Die Tendenz, sogar dumpfen Maschinen ein Geschlecht zuzuschreiben, wirft ein Licht auf die unsere Denkweise. Kompetent und sachlich? Wahrscheinlich männlich. Warmherzig und hilfsbereit? Wahrscheinlich weiblich. Das ist soziokulturell geprägt und betrifft wie gesagt auch, wie wir mit Technik umgehen. Es ist fast, als würden wir einer faktisch geschlechtslosen Maschine unsere eigenen Vorstellungen von Männlichkeit und Weiblichkeit überstülpen. Geringe „social cues“ wie z.B die ARt und Weise zu kommunizieren, reichen einfach schon aus damit dieser weitgehend automatische, unbewusste Prozess in Gang gesetzt wird. Dazu hatte Melanie Hoff aus den USA mal ein cooles Experiment gemacht. Sie hat Kinder zeichnen lassen, wie sei denken, dass Alexa aussieht. Spoiler: Es waren fast nur Frauen in den Zeichnungen (ok es waren auch ein paar dreiäugige Monster dabei).

Image: https://sfpc.study/fundraiser/alexa-zine

Wird es eine Zukunft ohne Klischees geben?

Tja, ich würde sagen dass liegt wohl an uns selbst. Die Frage ist, Warum steckt Kompetenz und Sachlichkeit automatisch im Maßanzug und Emotion und Mitgefühl im Kleid? Und vor allem: Warum packen wir das auch noch auf Maschinen? Also, lasst uns aufhören, Maschinen in diese klischeebehafteten Schubladen zu stecken. KI ist hier, um uns zu helfen – egal, ob sie unsere Statistikfragen beantwortet oder eure Social Media Posts erstellt. Und ehrlich? Sehr sehr wahrscheinlich ist es der KI auf der anderen Seite des Bildschirms auch echt egal, ob wir sie dabei männlich oder weiblich einkategorisieren.

In diesem Sinne, happy Mittwoch. Ihre SK

Wong, J., & Kim, J. (2023). ChatGPT Is More Likely to Be Perceived as Male Than Female (arXiv:2305.12564). arXiv. https://doi.org/10.48550/arXiv.2305.12564

Fiske, S. T., Cuddy, A. J. C., Glick, P., & Xu, J. (2002). A model of (often mixed) stereotype content: Competence and warmth respectively follow from perceived status and competition. Journal of Personality and Social Psychology, 82(6), 878–902. https://doi.org/10.1037/0022-3514.82.6.878